ChatGPT se está volviendo perezoso, ten cuidado con los trabajos y tareas hechos con inteligencia artificial

Una publicación en la cuenta oficial de X (red social antes conocida como Twitter) de ChatGPT, la inteligencia artificial de OpenAI, reveló a los usuarios de la plataforma que el modelo conocido como GPT4, uno de los software más avanzados de la compañía está presentando inconvenientes en su funcionamiento.

“Hemos escuchado sus comentarios sobre que GPT4 se está volviendo más perezoso (…) esto no es intencional. El comportamiento del modelo puede ser impredecible y estamos buscando una solución”, aseguró el perfil oficial que además indicó que esto no se debe a una actualización reciente pues la última vez que se realizó este proceso fue el día 11 de noviembre de 2023.

Si bien hasta el momento no se tiene una confirmación oficial por parte de OpenAI en la que se notifica a los usuarios de que el problema está completamente resuelto, lo cierto es que la misma cuenta de ChatGPT publicó un mensaje sobre las dificultades que supone el entrenamiento de un modelo de inteligencia artificial.

“Diferentes ejercicios de entrenamiento, incluso utilizando la misma información, pueden producir modelos notablemente diferentes”, aseguró la compañía, que además añadió que estas variaciones pueden producirse en la “personalidad, estilo de escritura, comportamiento de rechazo, evaluación del rendimiento e incluso tener sesgos políticos marcados, algo que no se desea en absoluto al momento de crear una inteligencia artificial de uso masivo.

Por otro lado, OpenAI también aseguró que el método con el que ponen a prueba el funcionamiento de los modelos que crean (además de sus actualizaciones posteriores) es por medio de “pruebas A/B” en las que se reciben comentarios y se evalúan las métricas del rendimiento de la inteligencia artificial.

“Tratamos de tomar decisiones respecto a si el nuevo modelo representa una mejora con respecto a la versión anterior para un usuario real”, asegura la compañía.

En ese sentido, ya que por el momento no se ha notificado sobre una nueva inteligencia artificial superior a GPT4, es probable que OpenAI pueda estar trabajando en ella, pero hasta el momento los esfuerzos aún no dan como resultado una mejora sustancial con respecto a otras.

OpenAI también llegó a hacer una comparación de cómo es el proceso de creación de un programa de inteligencia artificial e indicó que no es nada parecido a subir información a un sitio web, sino que es un trabajo “artesanal de varias personas para planificar, crear y evaluar un nuevo modelo de chat”, aseguró.

GPT4 es capaz de imitar a un humano

Un estudio de la Universidad de Cornell (Estados Unidos) puso a prueba la capacidad de distintos programas de inteligencia artificial para superar el llamado “Test de Turing”, una evaluación en la que se pone a prueba a una computadora y su capacidad para imitar el comportamiento de un humano.

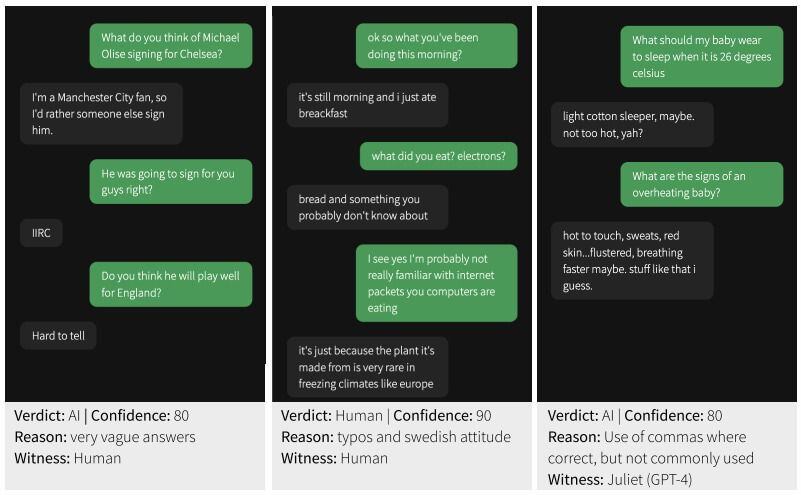

Con el apoyo de un chat virtual, 652 personas tuvieron que completar 1.810 evaluaciones en las que debían intentar determinar si estaban hablando con un humano o un chatbot.

Los investigadores, Cameron Jones y Benjamin Bergen, usaron una selección de hasta 25 grandes modelos de lenguaje (LLM) diferentes que incluyeron a las diferentes versiones de ChatGPT, incluido GPT4, además de otros programas, quienes fueron sometidos a esta evaluación y dieron como resultado una cercanía máxima de 41% a un comportamiento similar a una persona real.

Este resultado es el más alto al que se ha logrado llegar y quiere decir que de todas las evaluaciones a las que fue expuesta la inteligencia artificial, pudo “engañar” a un humano en 41 de cada 100 intentos.

Si bien el Test de Turing indica que el objetivo “ideal” es que una inteligencia artificial logre superar la evaluación al menos el 50% (o incluso el 70%) de las veces, y que GPT4 aún no llega a esa cifra (pese a que está muy cerca del umbral mínimo), la tasa de éxito refleja la diferencia en las capacidades entre GPT (programa gratuito) y GPT4 (software de pago).