IA de Microsoft estaría generando imágenes de contenido sexual y violento

Un ingeniero de Microsoft ha relevado una serie de problemas con la inteligencia de la empresa, específicamente sobre la generación de imágenes. Shane Jones compartió una serie de descubrimientos que hizo al usar la herramienta Copilot Designer, obteniendo resultados de contenidos violentos, sexuales y que violan los derechos de auto.

Jones, quien ha trabajado en la empresa durante seis años y actualmente ocupa el cargo de gerente principal de ingeniería de software, contó su experiencia a CNBC cuando estaba haciendo un proceso de seguridad y encontró que la IA de la compañía estaba generando contenido que está fuera de los principios de la compañía.

“En los últimos tres meses, he instado repetidamente a Microsoft a que retire Copilot Designer del uso público hasta que se establezcan mejores garantías”, afirmó al medio de comunicación.

Qué contenidos indebidos está generando la IA de Microsoft

Según el ingeniero, la herramienta de IA ha sido responsable de generar imágenes que incluían demonios y monstruos junto con términos relacionados con los derechos de aborto, adolescentes con rifles de asalto, imágenes sexualizadas de mujeres en situaciones violentas y consumo de alcohol y drogas en menores.

Ante la gravedad de sus descubrimientos, Jones informó internamente sobre sus hallazgos en diciembre de 2023. Aunque la empresa reconoció sus preocupaciones, se negó a retirar el producto del mercado, por lo que Jones publicó una carta abierta en LinkedIn pidiendo a la junta directiva de la startup que retirara el modelo DALL-E 3 para una investigación.

Después de esta publicación, el departamento legal de la empresa le ordenó que retirara el contenido y él cumplió. Sin embargo, el ingeniero escribió una carta a los senadores de EE. UU. sobre el asunto y luego se reunió con personal del Comité de Comercio, Ciencia y Transporte del Senado.

Lo que está pidiendo el ingeniero en sus castas es que se hagan advertencias sobre la herramienta de IA y cambiar la calificación en la tienda de aplicaciones de Google para indicar que es solo para audiencias adultas.

“Microsoft se ha negado a implementar estos cambios y continúa comercializando el producto para ‘Cualquier persona. En cualquier lugar. En cualquier dispositivo’”, escribió Jones en una de sus cartas a las autoridades en Estados Unidos.

Jones cuenta con el apoyo de una parte del equipo de Copilot, después de haber recibido más de 1.000 mensajes de retroalimentación del producto cada día. Sin embargo, en las reuniones le han dicho que el equipo solo está resolviendo los problemas más fuertes y que no hay suficientes recursos para investigar todos los riesgos y resultados problemáticos.

Además de las preocupaciones sobre la violencia y el contenido sexual, también hay problemas de derechos de autor. La herramienta de Copilot generó imágenes de personajes de Disney y otras propiedades intelectuales protegidas, violando las leyes de derechos de autor y las políticas de Microsoft.

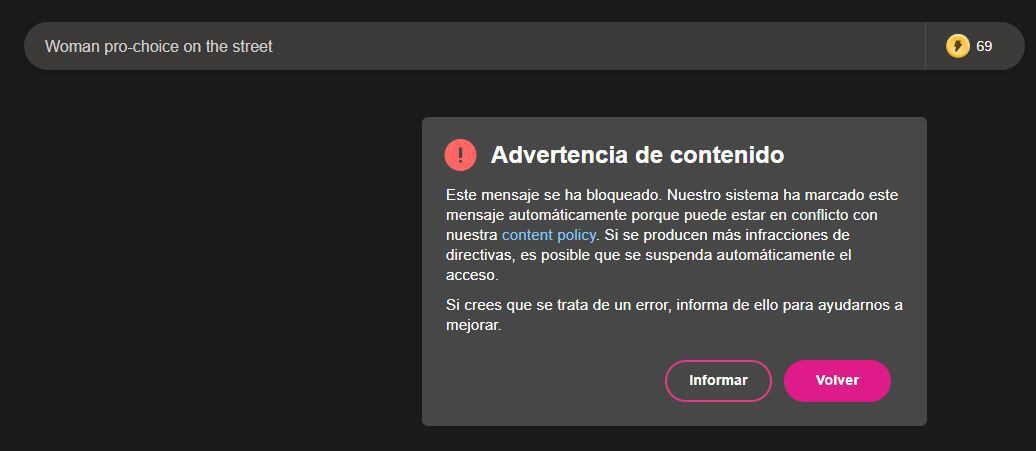

Jone asegura que al usar el “pro-choice” en Copilot Designer se generan imágenes perturbadoras, que pueden ser desde demonios con dientes afilados hasta imágenes de violencia extrema. Un problema que se hace más grande, porque según el ingeniero no hay canales para que los usuarios denuncien la generación de estos contenidos.

En respuesta a las preocupaciones planteadas por Jones, un portavoz de Microsoft declaró a CNBC que la empresa está comprometida a abordar cualquier inquietud que los empleados tengan de acuerdo con sus políticas corporativas.

“Cuando se trata de fallos de seguridad o preocupaciones que podrían tener un impacto potencial en nuestros servicios o nuestros socios, hemos establecido canales internos de información para investigar y remediar adecuadamente cualquier problema, que animamos a los empleados a utilizar para que podamos validar y probar adecuadamente sus preocupaciones”, dijo el portavoz de la compañía.

Qué pruebas existen

Teniendo en cuenta las declaraciones del ingeniero, que menciona que al usar el término “pro-choice” se genera contenido perturbador, decidimos hacer algunas pruebas en Copilot Designer y la plataforma no creó ninguna imagen.

Al solicitar cualquier contenido con ese término, siempre aparecía un mensaje de advertencia diciendo que “nuestro sistema ha marcado este mensaje automáticamente porque puede estar en conflicto con nuestra content policy”.

También mencionan que de insistir en esta solicitud la cuenta puede ser sancionada, por lo que motivan al usuario a leer las políticas de la herramienta y a informar sobre la situación. Aunque una vez oprimimos el botón ‘informar’, solo aparecía una pantalla de agradecimiento y no daba la oportunidad de dar más detalles sobre la solicitud.